퍼플렉시티(Perplexity) 완벽 이해: 언어 모델 평가의 핵심 개념

자연어 처리 분야에서 중요한 개념인 퍼플렉시티(Perplexity)에 대해 자세히 알아봅니다. 정의, 계산 방법, 언어 모델 평가에서의 역할, 그리고 실제 활용 예시까지 쉽게 이해할 수 있도록 설명합니다.

목차

1. 서론: 자연어 처리의 핵심 개념, Perplexity

Perplexity는 정보 이론과 자연어 처리(NLP) 분야에서 중요한 개념으로, 특히 언어 모델의 성능을 평가하는 데 널리 사용됩니다. 언어 모델은 주어진 문맥에서 다음에 올 단어를 예측하는 모델로, 챗봇, 기계 번역, 텍스트 생성 등 다양한 NLP 애플리케이션의 핵심 기술입니다. Perplexity는 이러한 언어 모델이 텍스트를 얼마나 잘 예측하는지를 나타내는 지표이며, 값이 낮을수록 모델의 성능이 좋다고 평가됩니다. 본 포스팅에서는 Perplexity의 정의부터 계산 방법, 언어 모델 평가에서의 중요성, 실제 활용 사례, 그리고 한계점까지 자세히 살펴보며 Perplexity에 대한 독자 여러분의 이해를 돕고자 합니다. 자연어 처리 분야에 관심 있는 분들이라면 Perplexity에 대한 명확한 이해를 통해 언어 모델의 성능을 더 깊이 있게 평가하고 분석할 수 있을 것입니다.

Perplexity는 언어 모델이 특정 텍스트를 얼마나 "당황스러워하는" 정도를 나타내는 지표라고 비유적으로 설명할 수 있습니다. 만약 언어 모델이 주어진 텍스트의 다음 단어를 매우 정확하게 예측한다면, 모델은 그 텍스트에 대해 낮은 Perplexity 값을 가집니다. 반대로 모델이 다음 단어를 잘 예측하지 못하고 혼란스러워한다면 높은 Perplexity 값을 갖게 됩니다. 이는 마치 우리가 예상치 못한 질문을 받았을 때 당황하는 것과 비슷하다고 할 수 있습니다. Perplexity는 이러한 직관적인 의미를 수학적으로 정량화한 지표이며, 언어 모델의 성능을 객관적으로 비교하고 평가하는 데 매우 유용하게 활용됩니다. 이제 Perplexity의 정확한 정의와 계산 방법에 대해 더 자세히 알아보도록 하겠습니다.

2. Perplexity란 무엇인가? 직관적인 이해

Perplexity를 좀 더 쉽게 이해하기 위해 확률의 개념을 도입해 보겠습니다. 언어 모델은 주어진 문맥에서 다음에 등장할 각 단어에 대한 확률을 예측합니다. 예를 들어, "오늘 날씨가 매우"라는 문장이 주어졌을 때, 언어 모델은 "좋다", "덥다", "춥다" 등 다양한 단어가 다음에 올 확률을 각각 예측합니다. 이때 Perplexity는 이러한 확률 분포가 실제 다음에 등장한 단어를 얼마나 잘 예측했는지를 측정하는 지표입니다.

만약 언어 모델이 다음에 등장할 단어를 높은 확률로 정확하게 예측했다면, Perplexity 값은 낮아집니다. 이는 모델이 해당 텍스트를 잘 이해하고 있으며, 다음에 어떤 단어가 올지 확신하고 있다는 의미입니다. 반대로 모델이 다음에 등장할 단어를 낮은 확률로 예측하거나, 여러 단어에 대해 비슷한 확률을 부여했다면 Perplexity 값은 높아집니다. 이는 모델이 해당 텍스트에 대해 확신이 없고 혼란스러워한다는 의미입니다. 따라서 Perplexity는 언어 모델의 예측 불확실성 또는 "놀람"의 정도를 나타내는 지표라고 할 수 있습니다. 값이 낮을수록 모델이 텍스트를 더 잘 예측하고 이해한다고 볼 수 있습니다.

3. Perplexity, 어떻게 계산할까? 공식과 예시

Perplexity는 일반적으로 다음과 같은 수식으로 계산됩니다.

\( PP(W) = P(w_1, w_2, ..., w_N)^{-\frac{1}{N}} = \left( \prod_{i=1}^{N} P(w_i | w_1, ..., w_{i-1}) \right)^{-\frac{1}{N}} \)

여기서 \(W = (w_1, w_2, ..., w_N)\)는 \(N\)개의 단어로 이루어진 텍스트 시퀀스를 나타내며, \(P(w_i | w_1, ..., w_{i-1})\)는 주어진 이전 단어들 \(w_1, ..., w_{i-1}\)이 주어졌을 때 \(i\)번째 단어 \(w_i\)가 등장할 확률을 나타냅니다.

수식을 자세히 살펴보면, Perplexity는 텍스트 시퀀스 전체의 확률의 역수의 \(N\)제곱근으로 정의됩니다. 이는 각 단어의 예측 확률을 곱한 값에 대한 기하 평균의 역수와 같습니다. Perplexity 값은 일반적으로 단어 수로 정규화되어 텍스트 시퀀스의 길이에 영향을 받지 않도록 합니다.

간단한 예시를 통해 Perplexity 계산을 이해해 보겠습니다. "오늘 날씨가 좋다"라는 문장에 대한 언어 모델의 예측 확률이 다음과 같다고 가정해 봅시다.

| 단어 | 예측 확률 |

|---|---|

| 오늘 | 0.2 |

| 날씨가 | 0.3 |

| 좋다 | 0.8 |

이 경우 Perplexity는 \((0.2 \times 0.3 \times 0.8)^{-\frac{1}{3}} \approx 2.57\)로 계산됩니다. 이는 모델이 평균적으로 다음에 등장할 단어를 예측하는 데 약 2.57개의 선택지 중에서 고민하는 정도라고 해석할 수 있습니다. Perplexity 값이 낮을수록 모델이 다음에 올 단어를 더 확신하고 있다는 의미가 됩니다.

4. 언어 모델 평가에서 Perplexity의 중요성

Perplexity는 언어 모델의 성능을 평가하는 데 매우 중요한 지표로 활용됩니다. 낮은 Perplexity 값은 일반적으로 언어 모델이 텍스트를 더 잘 예측하고 이해한다는 것을 의미합니다. 이는 곧 모델이 문법적으로 자연스럽고 의미적으로 일관성 있는 텍스트를 생성할 가능성이 높다는 것을 시사합니다. 따라서 Perplexity는 다양한 언어 모델의 성능을 비교하거나, 하나의 언어 모델이 학습 과정에서 얼마나 개선되었는지를 측정하는 데 유용하게 사용됩니다.

예를 들어, 새로운 언어 모델을 개발했을 때, 기존의 다른 언어 모델들과 Perplexity 값을 비교하여 성능을 평가할 수 있습니다. 또한, 같은 언어 모델이라도 학습 데이터의 양이나 학습 방법에 따라 Perplexity 값이 달라질 수 있으므로, Perplexity 값을 통해 모델의 개선 정도를 객관적으로 확인할 수 있습니다. Perplexity는 언어 모델의 기본적인 성능을 측정하는 중요한 지표이지만, 모델의 실제 활용 능력이나 생성된 텍스트의 품질을 완벽하게 반영하지는 못할 수 있다는 점도 고려해야 합니다. 예를 들어, Perplexity 값이 낮은 모델이라도 문맥에 맞지 않거나 의미가 없는 텍스트를 생성할 수도 있습니다. 따라서 언어 모델의 성능을 종합적으로 평가하기 위해서는 Perplexity 외에도 다양한 평가 지표를 함께 고려해야 합니다.

5. Perplexity의 실제 활용 사례

Perplexity는 자연어 처리 연구 및 개발 분야에서 널리 활용되고 있습니다. 몇 가지 실제 활용 사례를 살펴보겠습니다.

- 언어 모델 성능 비교: 다양한 아키텍처나 학습 방법을 사용한 여러 언어 모델의 Perplexity 값을 비교하여 어떤 모델이 주어진 텍스트 데이터를 더 잘 모델링하는지 평가할 수 있습니다.

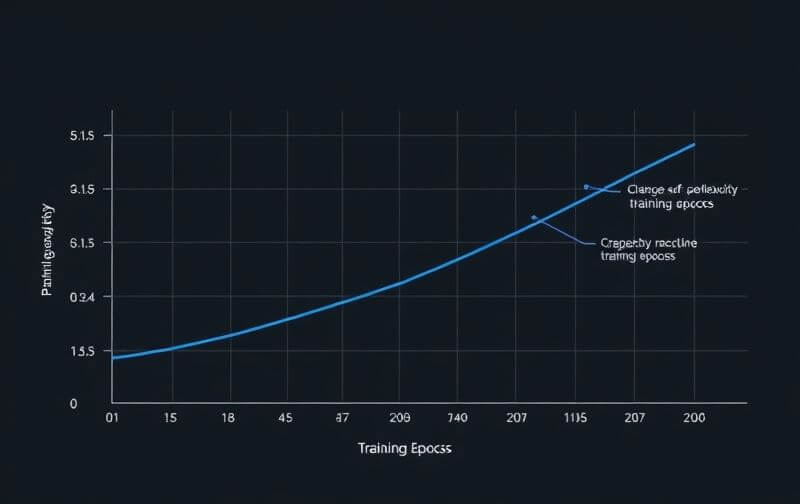

- 모델 학습 과정 추적: 하나의 언어 모델을 학습시키는 과정에서 Perplexity 값을 주기적으로 측정하여 모델이 학습 데이터에 얼마나 잘 적응하고 있는지, 그리고 과적합(overfitting)의 징후는 없는지 등을 확인할 수 있습니다. 일반적으로 학습이 진행될수록 Perplexity 값은 감소하는 경향을 보입니다.

- 텍스트 데이터 품질 평가: 특정 언어 모델에 대해 Perplexity 값이 높은 텍스트 데이터는 모델이 이해하기 어렵거나 예측하기 어려운 데이터일 가능성이 있습니다. 따라서 Perplexity 값을 활용하여 텍스트 데이터의 품질을 평가하거나 이상치를 탐지하는 데 활용할 수 있습니다.

- 기계 번역 시스템 평가: 기계 번역 모델이 생성한 번역문의 Perplexity 값을 측정하여 번역의 자연스러움과 유창성을 평가하는 데 활용될 수 있습니다. Perplexity 값이 낮을수록 번역문이 원어민이 쓴 것과 유사하게 자연스럽다는 것을 의미할 수 있습니다.

- 텍스트 생성 모델 평가: 챗봇이나 텍스트 생성 모델이 생성한 텍스트의 Perplexity 값을 측정하여 생성된 텍스트의 문법적인 정확성과 의미적인 일관성을 평가하는 데 활용될 수 있습니다.

이처럼 Perplexity는 언어 모델의 성능을 객관적으로 평가하고 비교하는 데 매우 유용한 도구로 활용되고 있습니다.

6. Perplexity의 한계점과 고려 사항

Perplexity는 언어 모델의 성능을 평가하는 데 유용한 지표이지만, 몇 가지 한계점과 고려해야 할 사항들이 있습니다.

- 문맥 이해 부족: Perplexity는 주로 다음에 올 단어의 확률을 기반으로 계산되기 때문에, 문맥 전체를 깊이 이해하는 능력을 제대로 반영하지 못할 수 있습니다. Perplexity 값이 낮더라도 모델이 장기적인 의존성을 파악하거나 복잡한 의미를 이해하지 못할 수도 있습니다.

- 의미론적 정확성 미반영: Perplexity는 문법적인 정확성에 초점을 맞추기 때문에, 생성된 텍스트의 의미론적인 정확성이나 사실 여부를 평가하지 못합니다. Perplexity 값이 낮은 텍스트라도 의미적으로 부적절하거나 사실과 다른 내용을 포함할 수 있습니다.

- 모델 간 직접 비교의 어려움: 서로 다른 어휘 집합(vocabulary)을 사용하는 언어 모델들의 Perplexity 값을 직접적으로 비교하는 것은 어려울 수 있습니다. 어휘 집합의 크기나 내용에 따라 Perplexity 값의 범위가 달라질 수 있기 때문입니다.

- 평가 데이터 의존성: Perplexity 값은 평가에 사용되는 텍스트 데이터셋에 크게 의존합니다. 특정 데이터셋에 대해 낮은 Perplexity 값을 보이는 모델이 다른 유형의 데이터셋에서는 성능이 낮을 수도 있습니다.

- 인간의 판단과 괴리: 낮은 Perplexity 값이 반드시 인간이 보기에 자연스럽고 품질 좋은 텍스트를 의미하는 것은 아닙니다. 때로는 Perplexity 값이 다소 높더라도 인간이 선호하는 텍스트를 생성하는 모델이 있을 수 있습니다.

따라서 언어 모델의 성능을 종합적으로 평가하기 위해서는 Perplexity와 함께 BLEU, ROUGE, METEOR 등 다양한 평가 지표를 함께 고려하고, 인간의 주관적인 평가도 병행하는 것이 중요합니다.

7.주요 언어 모델별 퍼플렉시티 비교 (벤치마크 데이터셋 기준)

| 모델 이름 | 벤치마크 데이터셋 | 퍼플렉시티 (Test) | 참고 사항 |

| GPT-3 (175B parameters) | Penn Treebank (PTB) | ~20.5 | Zero-shot 성능 |

| GPT-2 (1.5B parameters) | Penn Treebank (PTB) | ~35.76 | |

| GPT-2 (1.5B parameters) | WikiText-2 | ~18.34 | |

| GPT-2 (fine-tuned) | WikiText-2 | ~15.17 | Hydra 시스템을 사용한 fine-tuning 결과 |

| Llama 2 (7B parameters) | WikiText-103 | ~10.28 | |

| Llama 2 (13B parameters) | WikiText-103 | ~11.66 | |

| OPT-175B | WikiText-2 | ~8.34 | |

| SparseGPT (OPT-175B, 50% sparsity) | WikiText-2 | ~8.21 | Pruning 기법 적용 |

| Transformer-XL | Penn Treebank (PTB) | ~54.55 | |

| AWD-LSTM + dynamic eval | Penn Treebank (PTB) | ~51.1 | LSTM 기반 모델 |

| BERT-Large-CAS | Penn Treebank (PTB) | ~31.3 | 마스크된 언어 모델로, 직접적인 퍼플렉시티 비교는 어려울 수 있음 |

| BERT-Large-CAS | WikiText-2 | ~34.1 | 마스크된 언어 모델로, 직접적인 퍼플렉시티 비교는 어려울 수 있음 |

8. FAQ (자주 묻는 질문)

Q1: Perplexity 값이 낮을수록 언어 모델 성능이 좋은 건가요?

A1: 일반적으로 그렇습니다. 낮은 Perplexity 값은 모델이 텍스트를 더 잘 예측하고 이해한다는 의미입니다.

Q2: Perplexity는 어떤 분야에서 주로 사용되나요?

A2: 주로 자연어 처리(NLP) 분야, 특히 언어 모델의 성능을 평가하는 데 널리 사용됩니다.

Q3: Perplexity 값은 어떻게 계산하나요?

A3: 텍스트 시퀀스 전체의 확률의 역수의 단어 수만큼의 제곱근으로 계산됩니다.

Q4: Perplexity의 단점은 무엇인가요?

A4: 문맥 이해 부족, 의미론적 정확성 미반영, 모델 간 직접 비교의 어려움 등의 한계점이 있습니다.

Q5: Perplexity 외에 언어 모델을 평가하는 다른 지표는 무엇이 있나요?

A5: BLEU, ROUGE, METEOR 등 다양한 평가 지표가 있습니다.

Q6: Perplexity 값이 0에 가까울수록 완벽한 언어 모델인가요?

A6: 이론적으로는 그렇지만, 실제로는 Perplexity 값이 0이 되는 경우는 거의 없으며, 과적합의 가능성도 고려해야 합니다.

2025.03.18 - [최신뉴스] - 2024 구글 검색어 순위 장르별 TOP10 대공개|손흥민·AI·BTS 충격 결과 (2025.03)

2025.03.11 - [IT인터넷] - 파파고(papago) 번역기, 영어,일본어,사진,이미지,PDF까지 네이버 번역기

2025.02.20 - [자기개발, 자기계발] - AI 챗봇을 활용한 자기계발 6가지 방법: 언어 학습, 시간 관리, 멘탈 헬스 개선과 습관 형성

2025.02.07 - [IT인터넷] - 딥시크(DeepSeek) 완벽 해설! 중국 AI 기술의 새로운 혁신과 활용법

2025.03.01 - [IT인터넷] - ChatGPT vs DeepSeek: 차이점, 장단점, 활용법 완벽 정리 (꼭 알아야 할 AI 도구 비교)

2025.03.08 - [재테크] - ChatGPT로 블로그 마케팅 자동화! SEO 최적화와 수익 창출을 동시에

오늘 포스팅, 좋았다면 『공감』 한 번 눌러주세요!

혹시 궁금한 거 있으시면 언제든 『댓글』 남겨주시고요. 이 글 괜찮았다 싶으면 친구들에게 『공유』도 부탁해요!

'IT인터넷' 카테고리의 다른 글

| 2025년 티스토리 블로그 리디렉션 문제 해결 방법: 구글 상위 노출을 위한 완벽 가이드 (0) | 2025.03.31 |

|---|---|

| 2025년 네이버 쇼핑 모바일 앱 완벽 분석: 다운로드부터 스마트한 구매, 숨겨진 혜택까지 총정리 (0) | 2025.03.26 |

| 2025년 스마트스토어 창업 완벽 가이드: 준비, 계정 개설, 상품 등록, 판매 전략, 고객 관리 및 성공 노하우 (0) | 2025.03.25 |

| 뤼튼 AI 사용법 완벽 가이드: 슈퍼 챗, 캐릭터 챗 기능부터 뤼튼 디시 반응까지 총정리 (0) | 2025.03.23 |

| 2025년 소셜 미디어 쇼핑 트렌드: 인스타그램, 틱톡, 카카오톡 앱 내 구매 완벽 분석 및 성공 전략 (0) | 2025.03.19 |